文章详情页

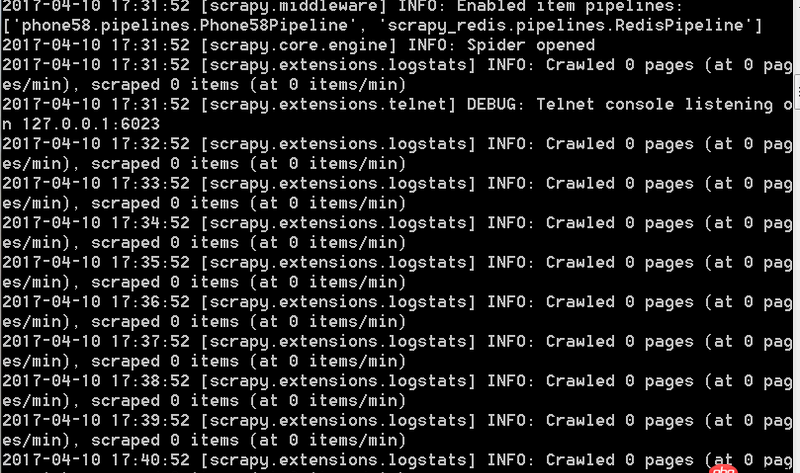

python - 基于scrapy-redis的分布式爬虫运行的时候不能正常运行 遇到的问题如下截图所示

浏览:90日期:2022-08-03 11:20:00

问题描述

爬虫运行时一直是这样的每一分钟出现一条这样的信息,无限循环。不能爬取下来数据

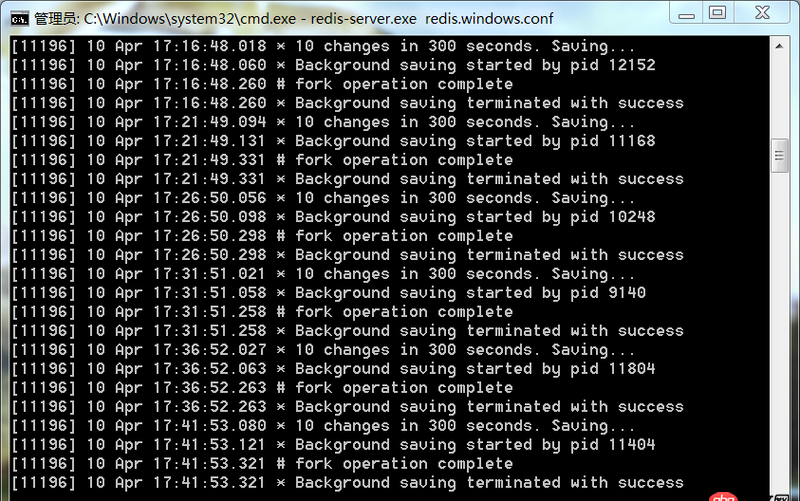

这是redis服务端的显示

这样是什么问题,望有高手可以为我解惑,谢谢。

问题解答

回答1:使用scrapy_redis,你要去投放url让spider去爬取,你投放了吗?比如

redis-cli lpush myspider:start_urls http://google.com

相关文章:

1. java - 创建maven项目失败了 求解决方法2. 运行python程序时出现“应用程序发生异常”的内存错误?3. java-se - 正在学习Java SE,为什么感觉学习Java就是在学习一些API。4. 一个走错路的23岁傻小子的提问5. python - 如何使用pykafka consumer进行数据处理并保存?6. javascript - SuperSlide.js火狐不兼容怎么回事呢7. node.js - 函数getByName()中如何使得co执行完后才return8. 主从备份 - 跪求mysql 高可用主从方案9. javascript - git clone 下来的项目 想在本地运行 npm run install 报错10. python - django 里自定义的 login 方法,如何使用 login_required()

排行榜

网公网安备

网公网安备