Linux实现文件内容去重及求交并差集

一、数据去重

日常工作中,使用Hive或者Impala查询导出来可能会存在数据重复的现象,但又不想重新执行一遍查询(查询时间稍长,导出文件内容多),因此想到了使用Linux命令将文件的内容重复数据进行去除。

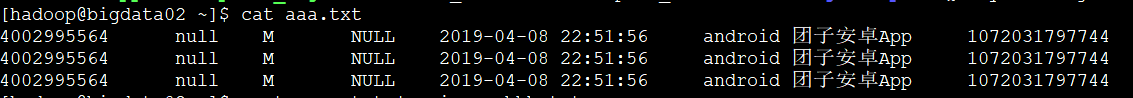

案例如下:

可以看到aaa.txx有3条重复数据

想去掉多余的数据,只保留一条

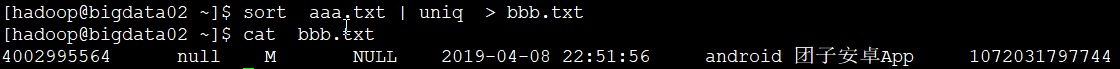

sort aaa.txt | uniq > bbb.txt

将aaa.txt文件中重复数据去掉,输出到bbb.txt

可以看到bbb.txt文件中只保留了一条数据

二、数据交、并、差

1)、交集(相当于user_2019 inner join user_2020 on user_2019.user_no=user_2020.user_no)

sort user_2019.txt user_2020.txt | uniq -d

2)、并集(相当于 user_2019.user_no union user_2020.user_no)

sort user_2019.txt user_2020.txt | uniq

3)、差集

user_2019.txt-user_2020.txt

sort user_2019.txt user_2020.txt user_2020.txt | uniq -u

user_2020.txt - user_2019.txt:

sort user_2020.txt user_2019.txt user_2019.txt | uniq -u

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持好吧啦网。

相关文章:

网公网安备

网公网安备